Sobre inteligencia

02 Oct 2024Me gustaría tratar de esbozar aquí una discusión que parece que no tiene fin entre los expertos en IA que escucho y leo en las redes sociales. Me refiero a la discusión sobre qué es la inteligencia general, dónde están los humanos, dónde están las máquinas e incluso dónde están los animales si nos pusiéramos todos en una escala.

Lo primero que quiero decir es que yo no soy un experto en IA ni un experto en ciencias cognitivas, solo intento resumir lo que entiendo de leer y escuchar a los expertos en las diferentes materias para tratar de aclarar mi propia opinión.

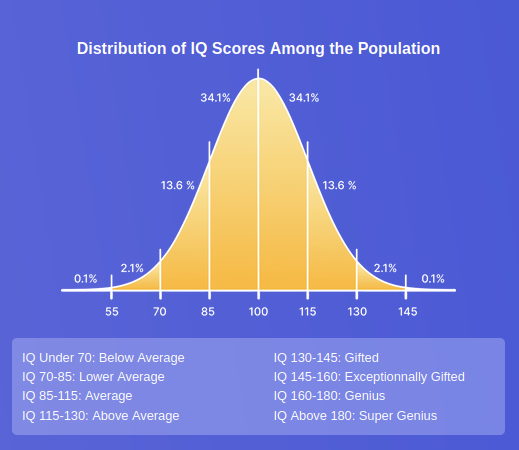

El segundo punto importante antes de empezar es que no existe un solo tipo de inteligencia, la “inteligencia” tal cual es un concepto demasiado amplio que la mayoría de las personas relacionamos con la capacidad de aprender, relacionar, entender conceptos complejos, resolver problemas, desenvolvernos en situaciones difíciles, etc. De hecho, si nos vamos al campo de la psicología, los llamados tests de inteligencia miden siempre varios aspectos diferentes como la comprensión lectora, el cálculo mental, la creatividad, pensamiento lógico, memoria… De cada una de esas características se hacen una serie de pruebas, que terminan en una nota; el conocido IQ o coeficiente intelectual no es más que una media de esas notas.

Como todas las medias, tiene sus problemas. Porque una persona puede ser brillante en un área y mediocre o mala en otras (y eso nos lleva a las definiciones de talento simple, talento complejo o sobredotación, según si un individuo está por encima del percentil 75-80% en una, varias o todas las áreas…) Pero más o menos es una forma aceptada de medir la inteligencia de una persona alfabetizada (la mayoría de las pruebas son por escrito, con lo que aunque seas un genio del nivel de Einstein o Mozart, si no sabes leer o escribir no puedes hacerlas).

Con todo eso para tener en cuenta como disclaimers, vayamos al meollo del asunto:

¿Puede la IA sobrepasar a los humanos?

Para mí esta es la clave, y quiero esbozar primero los dos bandos principales que veo entre los expertos:

En el primer grupo, a los que llamaré “humanistas” por falta de una palabra mejor, estarían los expertos en AI que consideran que los humanos somos el pináculo de la inteligencia, que la evolución nos ha dotado con una capacidad de abstracción, razonamiento y meta-cognición que no es alcanzable por medios artificiales.

Las más conocidas defensoras de esta postura son Timnit Grebu y Emily M. Bender, dos de las autoras del famoso paper sobre los “Stocastic parrots” Otros que podríamos incluir aunque no sean tan radicales podrían ser Gary Marcus o Margaret Mitchell, o incluso Yann LeCun. Cada uno tiene su propia visión del problema, pero todos más o menos coinciden en que los LLMs no se parecen a la inteligencia humana y nunca lo harán. Algunos de estos expertos pueden llegar a conceder que si dotáramos a un robot de inteligencia, y agencia y le diéramos sensores parecidos a los de los humanos, y suficiente capacidad de cómputo y memoria… (grounded intelligence) Tal vez, y solo tal vez, podría aprender a ser una especie de simulacro de humano.

Es importante notar que cuando estos expertos hablan de la imposibilidad de que las máquinas alcancen la inteligencia humana, no se refieren necesariamente a un “alma” o consciencia inefable, sino a diferencias fundamentales en cómo procesan la información los sistemas actuales de IA versus cómo lo hacen los cerebros biológicos. Su argumento principal es que el reconocimiento de patrones estadísticos, por muy sofisticado que sea, es cualitativamente diferente de la comprensión genuina que exhiben los humanos.

En el otro lado del espectro están aquellos que dicen que los humanos no somos más que un montón de heurísticas y sesgos cognitivos pegados y revueltos por la evolución a base de ensayo y error y que más que el pináculo de la inteligencia somos el mínimo viable para crear y mantener una cultura común. Este lado incluye a investigadores y emprendedores conocidos como Sam Altman, Dario Amodei, Ilya Sutskever o Geoffrey Hinton. Aunque normalmente no lo argumenten de la misma forma, su conclusión es que a mayor escala y mayor cantidad de datos, estos sistemas se harán más inteligentes y podrán realizar tareas más complejas, mucho más complejas de lo que cualquier persona podrá entender y a una velocidad mucho mayor.

Para ellos, la cultura y las relaciones entre conceptos son la verdadera inteligencia que nos propulsa hacia adelante como especie y nos permite crear sociedades, instituciones, compañías y demás agrupaciones y expresiones culturales que se perpetúan a sí mismas y que culminan en la IA. La IA no es más que la expansión de esa inteligencia colectiva, de esa cultura que se ha perdurado y que nos sobrevive a todos como humanos y por tanto puede alcanzar cotas mucho más altas si le damos entidad. A estos es a los que podríamos llamar trans-humanistas o doomers, según si piensan que la IA es una bendición o un riesgo existencial. Este es el grupo al que los medios dan más altavoz y el que escribe más libros, crea más hype y hace más lobby, pero nada de eso lo hace tener razón, y más cuando dentro del propio grupo hay tanta diferencia de opiniones en cuanto a lo que la IA supone para el progreso. Pero ese es un tema que no me interesa tanto como el hecho de que todos consideran que la IA será muy superior en inteligencia al ser humano.

Para mí estamos ante dos campos diametralmente opuestos que, sin embargo, nunca lo externalizan así. Ambos campos hablan como si su punto de vista fuera la única realidad posible y como si el otro estuviera también en esa realidad, pero no la entendiera del todo bien…

Mi pequeño intento de reflexión, por tanto, es el de exponer estos puntos de vista y tratar de analizarlos desde fuera, para ver dónde se sitúan en realidad.

¿Cómo de inteligentes somos en conjunto los humanos y hasta dónde pueden llegar las máquinas?

Empecemos por el rango de inteligencias humanas. Porque para mí no existe una inteligencia humana, como ambos bandos asumen, sino muchas. Incluso dentro del, más o menos socialmente aceptado IQ, tenemos todo un rango donde las personas con un IQ de 70 o inferior se consideran dependientes ya que no pueden llevar una vida normal por sí solas, hasta las personas con IQ 150 o superior, que se consideran genios por encima del 99.9% de la población. (Aún así, estos individuos son, teóricamente, uno de cada 1000, con lo que solo en España debería haber varias decenas de miles de ellos…) Pero, claro está, no es todo el IQ. La situación socioeconómica y cultural, sus conexiones sociales y la suerte de ese individuo tienen mucho que decir en su futuro. Y vaya por delante, no siente más, ni es más, una persona con más IQ ni siente menos ni es menos una persona con menos IQ.

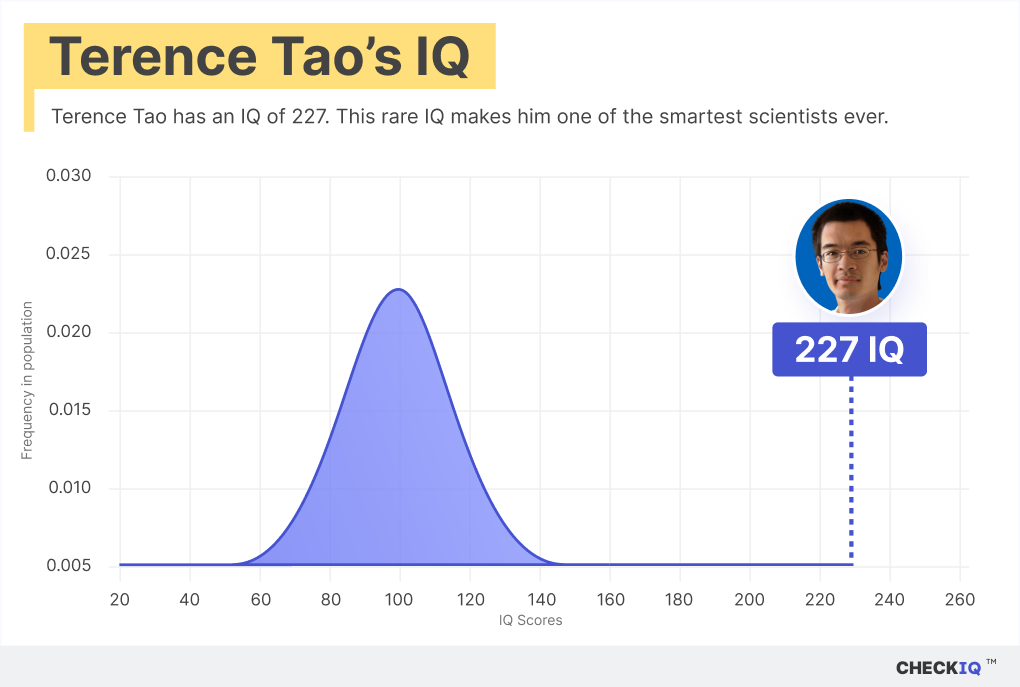

Además, como decía en el disclaimer del principio, uno puede ser un genio en matemáticas y a la vez ser disléxico, o sordo. Puedes tener oído perfecto pero nunca aprender a tocar un instrumento. Puedes ser muy bueno con los problemas lógicos y malo con los espaciales, etc., etc. La inteligencia tiene un millar de componentes diferentes que aún estamos aprendiendo a distinguir y que influyen, junto con la suerte y el entorno, en si una persona acaba siendo un premio Nobel o otro currito más.

Imagen que muestra dónde cae el IQ de Terence Tao dentro de la gráfica de IQ

Imagen que muestra dónde cae el IQ de Terence Tao dentro de la gráfica de IQ

Pero ¿entonces qué? ¿Somos “el tope” de la inteligencia? Visto toda esta variación no parece que sea así. Parece más bien que hay muchas inteligencias y que unas serán mejores para ciertas tareas que otras.

Los animales no encajan en nuestros tests de IQ, pero sí demuestran inteligencia de muchas formas cada vez mejor documentadas. Hay registros de cuervos resolviendo rompecabezas, de chimpancés recordando grupos de números en un abrir y cerrar de ojos (en el video de arriba), de orcas organizando planes de caza complejos, simios usando herramientas, lenguajes y dialectos animales, y animales “bilingües” (que son capaces de entender dos dialectos de regiones diferentes cuando se les muda de una a otra)… Y eso son solo inteligencias que nosotros podemos apreciar. Cada vez está más claro que los animales no tienen el cerebro solo para llevarlo de un sitio para otro o para gestionar sus órganos internos, sino que muchos de ellos son capaces de recordar, planificar, reconocerse, orientarse o coordinarse a niveles que no comprendemos.

Todo esto pinta una foto de la inteligencia mucho más rica y variada. La inteligencia no es un monolito, es más bien un conjunto de habilidades, agudezas, capacidades, conocimientos y competencias. Un chimpacé tiene más memoria de trabajo que nosotros y más agilidad, pero los chimpancés no han podido crear culturas y acumular conocimiento como nosotros. Una calculadora es órdenes de magnitud más rápida y fiable que el mejor ser humano haciendo aritmética o cálculo diferencial. Una base de datos es mucho más fiable, repetible y transparente que la memoria humana. Pero ambos carecen totalmente de agencia o de capacidad de interactuar con el mundo. Pero entonces, ¿qué puede hacer la IA? ¿Dónde cae en todo este espectro? ¿Hasta dónde llegará?

Ese es el siguiente problema. Voy a intentar reflejar en un par de gráficos lo que yo veo cuando los miembros de uno y otro bando hablan del tema.

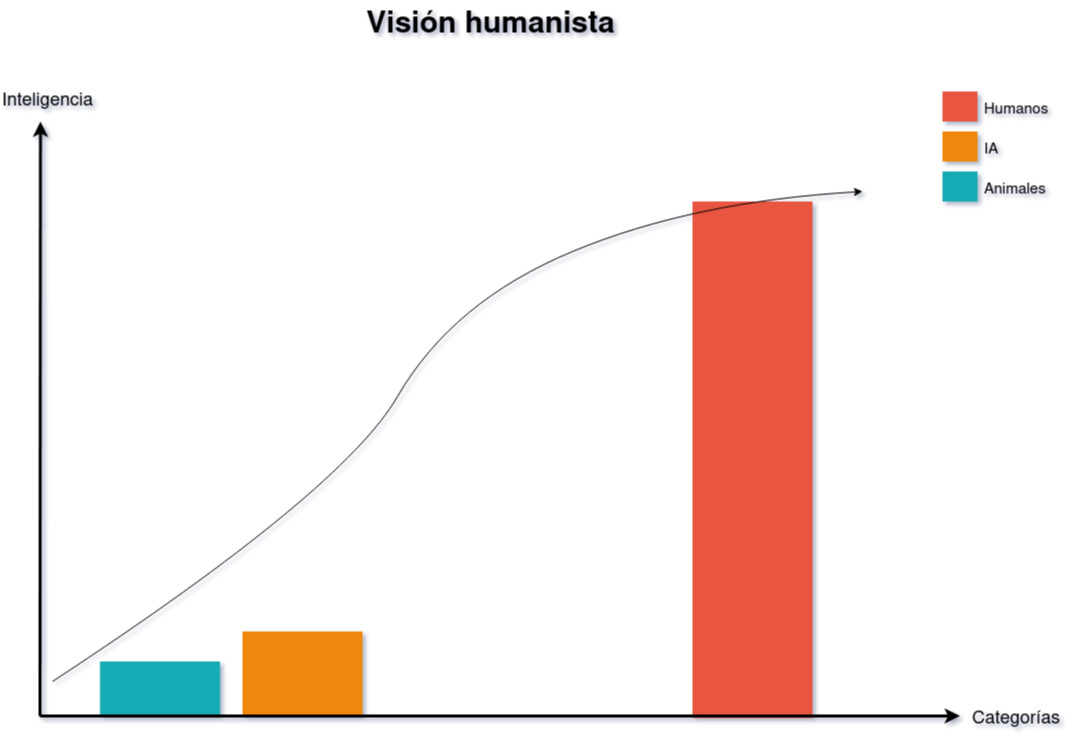

Para mí, los humanistas ven algo así:

Para ellos la IA claramente nunca alcanzará a los humanos. Apenas es más inteligente que un reptil o un pájaro, aún no está al nivel de otros mamíferos, y quedan décadas, si no siglos, para que una máquina pueda parecerse suficientemente a un humano como para sacar el debate a la palestra. Lo que estamos haciendo con este debate es distraer al público de los problemas importantes actuales del aprendizaje automático, como los sesgos, la propiedad intelectual de los datos de entrenamiento o las personas discriminadas por estos sistemas o por no tener acceso a ellos (todas preocupaciones totalmente legítimas pero que no son el foco de esta reflexión).

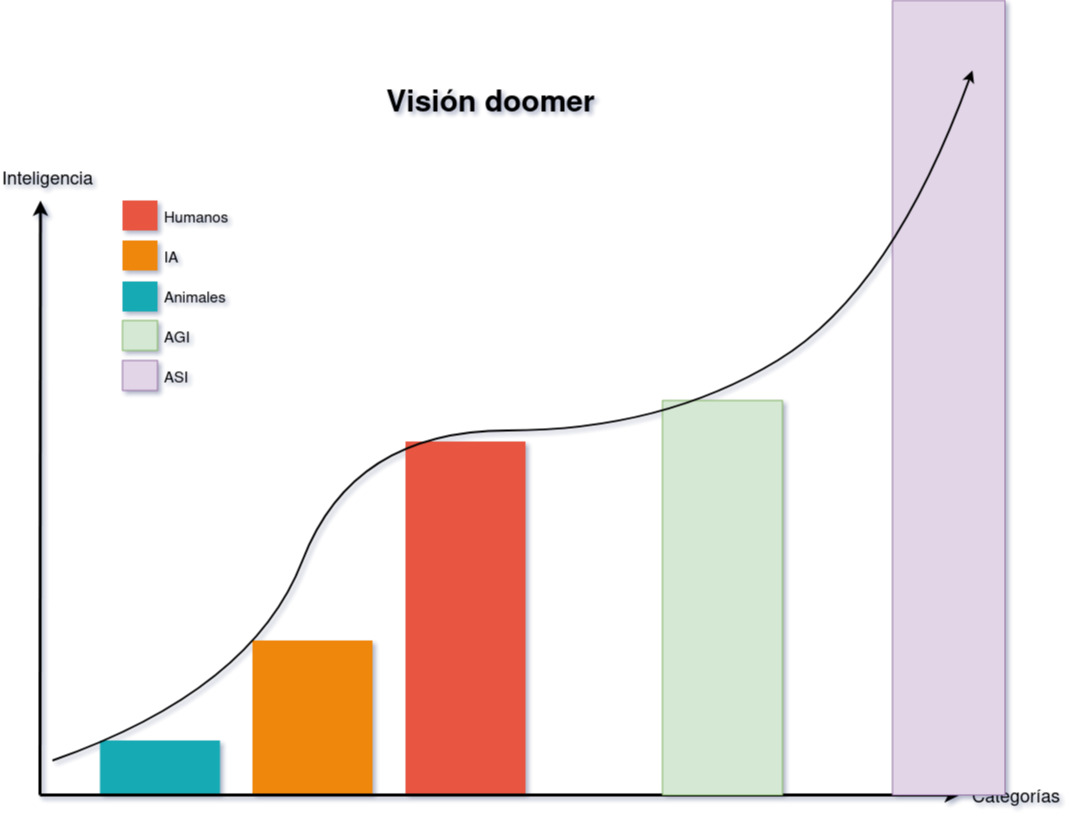

Mientras que los trans-humanistas y doomers ven algo así:

Para ellos es evidente que la IA más temprano que tarde superará a las personas y entonces no habrá retorno. En poco tiempo alcanzará velocidad de escape, no entenderemos lo que hace ni sus motivos para hacerlo y estaremos bajo su merced o su bendición eterna, según el sub-bando.

De hecho, después de hacer ese gráfico, encontré este otro, que es un gráfico de Leopold Aschenbrenner, uno de los niños prodigios de OpenAI que ahora está creando su propia empresa sobre superinteligencia:

En su ensayo “La década siguiente” Aschenbrenner asegura que la ASI es inevitable y que la escalada tanto en energía como en dinero y recursos para conseguirla seguirá imparable sin darse con ningún muro físico, económico ni social…

¿Quién tiene razón?

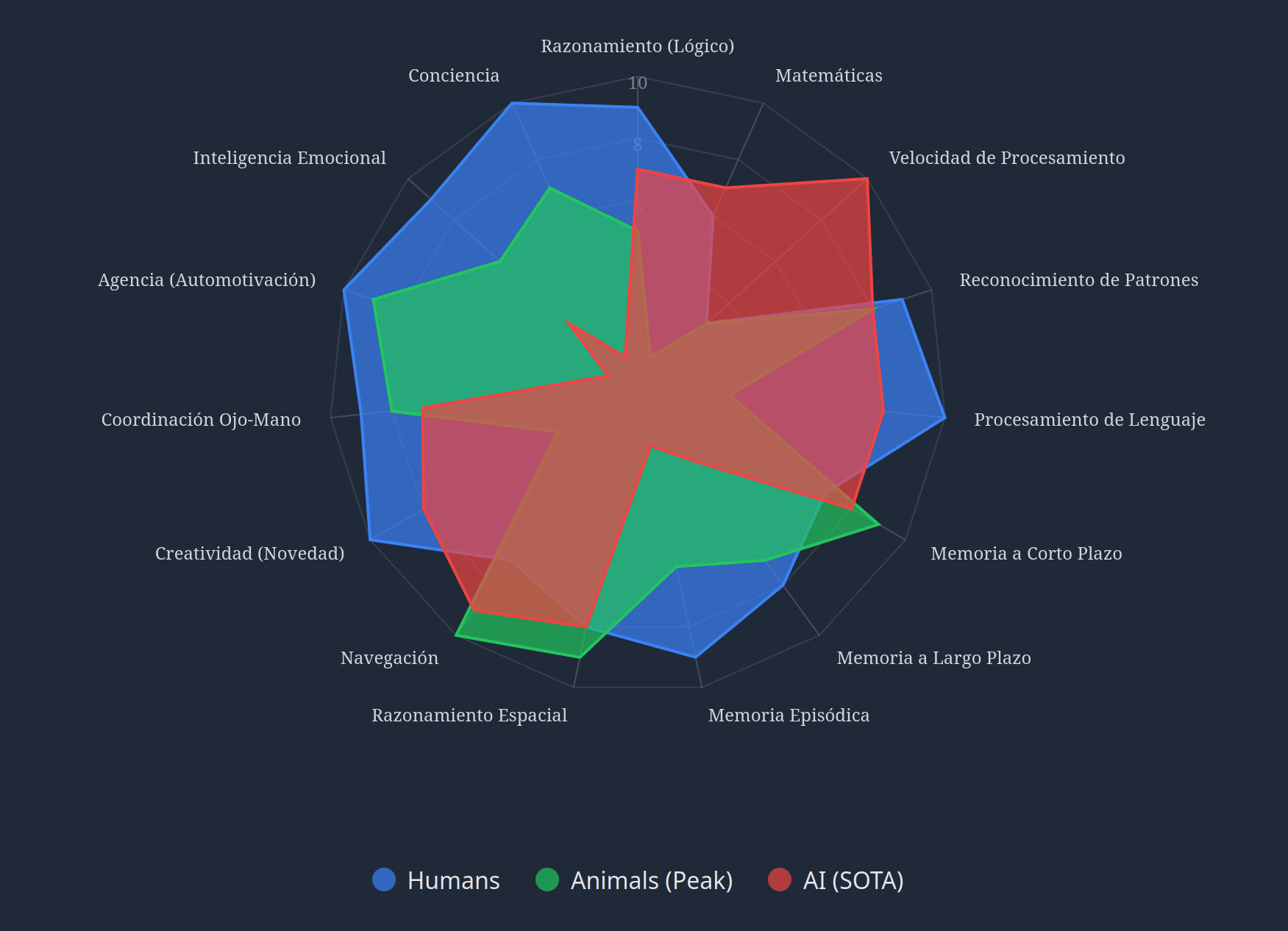

Solo el tiempo lo dirá. Creo que esta gran diferencia de opiniones, a parte del puro interés personal, está una visión diferente de lo que nos hace humanos e inteligentes. Unos miran las habilidades donde las IAs cometen errores y dicen “¿véis? nunca serán como nosotros, no entienden lo que están haciendo” otros miran aquellas tareas en las que la IA destaca o sobrepasa a los humanos y dicen “¿veis? cuando sea así en todas las demás disciplinas será imparable”. Pero después de ver toda la variabilidad que hay en los humanos y los animales, y de años de trabajo de ingeniería yo me inclino a pensar que es una cuestión siempre de compromisos, mejorar cada habilidad tiene un coste, determinadas tareas requieren de uso herramientas concretas o de un contexto o de unos datos que la IA aún no ha visto… La gráfica, para mi, es en realidad algo así:

Gŕafico generado con Google Gemini 2.5 pro (https://gemini.google.com/share/bb37aabfa351)

Es lo que Adrej Karpathy llamó “Jagged intelligence”

La Inteligencia Artificial General, o por sus siglas en inglés: AGI, será algo que estará en medio de todo ese espectro de inteligencias que exhibimos los humanos. Unas serán buenas en matemáticas y otras en reconocer y hablar sobre enfermedades. Habrá AGIs que no podrán ser “autónomas” aunque tengan algún tipo de memoria persistente y agencia. Como niños a los que hay que cuidar.

Incluso podríamos argumentar que sistemas actuales como GPT-4 o Claude 3.5 ya demuestran capacidades que superan a los humanos en ciertas áreas específicas (como el procesamiento de lenguaje o la recuperación de información), mientras que siguen siendo muy inferiores en otras (como el razonamiento causal o la comprensión del mundo físico). Los LLMs por si solos tienen muchos problemas y están lejos de tener la capacidad ejecutiva de un humano. No se les da bien planificar o ejecutar planes, no se les da bien razonar ni saber cuando realmente están respondiendo algo “simplemente porque suena bien”. Todo esto se está intentando paliar con arquitecturas que incluyen memorias externas, reintentos, control del output para evitar respuestas inapropiadas o control del input para evitar jail-break. Pero esto indica que hay mucho trabajo por hacer. Personalmente creo que el camino a la ASI es mucho más largo de lo que se presume ahora mismo y que estaremos unos cuantos años en este limbo de AIs muy potentes en algunos aspectos y muy torpes en otros, que supondrán grandes mejoras en muchos campos como estamos viendo con AlphaFold o Copilot, pero no serán AGIs.

Lo estamos viendo con los coches autónomos: ya conducen miles de kilómetros al día, pero sólo en ciudades concretas y en condiciones concretas, expandir esa red donde pueden operar con seguridad es un proceso lento porque cada ciudad y cada pais tiene diferente contexto.

El propio Sam Altman en su famoso ensayo “The intelligence Age” hablaba de ASI en “miles de días” una medida tan imprecisa como poco habitual. Miles de días podrían ser 3650 días (10 años), o podrían ser 9000 (~30 años) este ensayo debería haber enfriado las espectativas del mercado enormemente, pero no fue así, grandes empresas siguen gastando miles de millones con la esperanza de que si siguen aumentando el tamaño de los modelos y los datasets los modelos seguirán mejorando sin tocar techo.

La visión humanista no se equivoca en que los millones de años de evolución han conseguido sistemas increíblemente complejos, sofisticados y optimizados. La inteligencia es una ventaja evolutiva. Es lo que los doomers llaman un fin instrumental convergente: ser más inteligente es útil para conseguir muchas otras cosas, por lo tanto sea lo que sea que necesitas, ser más inteligente seguramente te ayude. Esto es lo que hizo crecer el cerebro de los homínidos hasta donde nos encontramos ahora: la capacidad de coordinarnos, de planificar, de rastrear una presa o tenderle una trampa, de comunicar conceptos abstractos en forma de palabras y finalmente la capacidad de crear una cultura común que perdure durante generaciones fue una ventaja sobre los otros animales y los otros homínidos. El problema de los humanistas es pensar que nosotros somos el techo o que la IA nunca podrá llegar a donde estamos y sobrepasarnos en muchos aspectos.

La realidad es que la inteligencia, tanto humana como artificial, es multidimensional, multisensorial y contextual. Un sistema puede ser extraordinariamente capaz en un dominio mientras es básico o incompetente en otro. Por eso me parece tan chocante la visión tanto de uno como el otro campo y no entiendo esta batalla argumentativa que no empieza por reconocer que es reduccionista al asumir que todos los humanos tenemos un sólo nivel de inteligencia y que todos estamos de acuerdo en lo que significa.

Actualización 04/12/2025

Blaise Agüera y Arcas toca este tema en sus charlas y en su libro “What is intelligence?” que es una teoría sobre cómo la vida y la inteligencia son computacionales, fundamentada en un montón de experimentos y en trabajos académicos. Es una locura y una maravilla de libro lo que llevo hasta ahora, increíblemente bien documentado y fundamentado, con cientos de referencias y además se puede leer online! https://whatisintelligence.antikythera.org/ El TLDR en su charlas por ejemplo en LongNow:

Referencias

Voy a añadir aquí al final algunos videos y enlaces más, además de los que he dejado salpicados por el artículo, para quien quiera seguir aprendiendo sobre estas dos visiones:

Timnit Grebru, sobre AGI: nunca la he visto atacar la pregunta directamente, siempre la redirige a hablar de sesgos, discriminación, capitalismo, ética y el mercado laboral, para ella la AGI no tiene sentido como concepto y el mero hecho de planteárselo es un intento de evadir los problemas reales que tenemos ahora mismo:

Geoffrey Hinton dió una charla a principios de 2024 donde expone las razones por las que cree que la IA superará la inteligencia humana:

Un video muy aclaratorio sobre AI ethics y el discurso que hay en este campo de ética vs riesgos de la IA es esta entrevista a Anca Dragan, responsable de seguridad en IA en Google Deepmind. Me gusta porque va desde los problemas éticos de decidir qué puede y qué no puede responder una IA (que sería parte del discurso de Timnit Gebru y los humanistas) hasta los problemas que puede presentar una IA con agencia para ejecutar acciones en el mundo en tu nombre o incluso de forma totalmente independiente (que es donde se centran los doomers) Me gusta mucho esta entrevista porque es un pequeño vistazo a todos los problemas que puede haber ahí detrás y puede verse claramente que esto no es un problema de blanco o negro, si no de un amplio espectro de problemas con una gran dificultad:

Sabine Hossenfelder es una física y divulgadora en youtube que escribe sobre temas difíciles como este, hace poco hizo un video sobre AI escaling y cómo es una inevitabilidad física que se de con un muro debido al llamado “decoupling of scales” Lo que significa que por mucho que mires cómo se comporta la materia a nivel macroscópico nunca podrás deducir que ocurre a nivel quántico. Esto según Abina aplica a muchos fenómenos, donde sin los datos y los instrumentos adecuados no puedes avanzar el conocimiento:

En la Navidad de 2024 OpenAI ha presentado un modelo que supera el benchmark Arc AGI, un benchmark que lleva en su nombre AGI y que François Chollet (que podríamos situar dentro del campo de los “humanistas” tal u como los he definido en este artículo) ha estado publicitando durante años como una prueba definitiva de generalización a la hora de resolver problemas. Creo que esto es un hito en el camino a la AGI y aunque el propio Chollet y otros humanistas ya estén empezando a mover la meta de nuevo y a declarar que necesitamos un benchmark mejor para medir la inteligencia, la verdad es que este era al que señalaban hasta ahora y este modelo de OpenAI demuestra que los modelos siguen saturando todos los benchmarks sin encontrar un muro real.

Google ha publicado un modelo de capacidad parecida (gemini 2.5 pro experimental) y en las últimas entrevistas y declaraciones tanto Demis Hassabis como David Silver han dejado claro que su intención es sobrepasar las capacidades humanas. Demis Hassabis ha declarado en varias ocasiones que AGI para él no es un modelo capaz de hacer lo que hace un humano medio, si no uno capaz de realizar tareas con la capacidad de “el mejor de los humanos” en cada campo. Es decir, alcanzar el nivel de AlphaGo, pero para cualquier tarea que pueda realizar una persona. Lo cual, para la mayoría de los expertos sería en realidad ASI (artificial super inteligence) En esta entrevista David Silver habla sobre esta idea y cómo en Google pretenden alcanzarla usando aprendizaje por refuerzo (Reinforcement Learning):